在现代计算架构中,从芯片到处理器再到数据中心,每个层级都涉及不同的互连技术。这些技术不仅保证了数据的快速、安全传输,还为新兴的计算需求提供了强有力的支持。本文主要介绍不同层级的网络互连技术,并揭示其在当前计算架构中是如何运作的。整篇文章可分为三个部分:系统级芯片Soc互连、处理器互连和数据中心互连。

SoC互连

互连创新始于最基本的层面:芯片上的系统。无论是位于芯片还是封装上,先进的互连意味着数据传输更快,性能更容易扩展。

PIPE(外围组件互连快速物理层协议)

PIPE是PCIe(外围设备互连快速通道)的物理层协议。PCIe是一种通用计算机总线标准,用于连接计算机内部的硬件设备,例如显卡、固态硬盘等。物理层协议定义了电气特性和信号传输方式,以确保硬件设备之间能够正确传输数据。PCIe通过提供不同的数据传输速率和接口来支持具有各种性能要求的设备的连接。

LPIF(逻辑物理层接口)

LPIF是处理器之间、处理器与加速器之间以及芯片与芯片(die-to-die)之间高速互连的接口标准。LPIF旨在提供一种灵活且可扩展的方式来支持不同的数据传输需求,并允许不同频率的设备之间进行通信。它支持多种协议,包括PCIe6.0、CXL3.0和UPI3.0。

CPI(CXLCache-Mem协议接口)

CPI是ComputeExpressLink(CXL)的一个组件,CXL是一种专门用于处理缓存和内存的通信协议。CXL是一种开放的高速互连技术,旨在连接CPU、GPU和其他加速器,实现它们之间的高速数据传输和资源共享。作为CXL的一部分,CPI定义了缓存和内存之间的接口标准,以支持高效的数据交换和一致性协议。

UFI(通用闪存存储接口)

UFI是一种通用的闪存存储接口标准,允许不同的存储设备以统一的方式进行通信和传输数据。UFI标准旨在提高存储设备的兼容性和性能,使设备能够快速高效地工作。

UCIe(通用晶片互连快线)

UCIe是一种新兴的开放行业标准互连技术,专专门为芯片到芯片的连接而设计。UCIe支持多种协议,包括标准的PCIe和CXL,以及通用的流协议或自定义协议。它的目标是采用标准的物理层和链路层对芯片间通信协议进行标准化,同时保持上层协议的灵活性。UCIe技术的出现是为了迎接摩尔定律减速带来的挑战。它通过封装和集成多个Chiplet来构建大型系统,以降低成本并提高效率。

处理器互连

在不同计算引擎、内存、I/O和其他外围设备之间移动数据需要一套专门的高带宽和低延迟互连技术。NVlink、PCIe、CXL和UPI等处理器互连技术使所有这些元素能够作为一个整体运行,支持设备之间的快速数据传输。

NVLink

NVLink是一种高速互连技术,专为连接NVIDIAgpu而设计。它允许gpu之间以点对点的方式进行通信,绕过传统的PCIe总线,实现更高的带宽和更低的延迟。NVLINK可以连接两个或多个gpu,实现高速数据传输和共享,为多gpu系统提供更高的性能和效率。

PCIe(外围组件互连快速标准)

它是一种通用的计算机总线标准,用于连接计算机内部的硬件设备,例如显卡、固态硬盘等。PCIe技术因其高速串行数据传输能力而被广泛使用,支持各种设备和广泛的应用场景,包括数据中心、人工智能和处理器互连。PCIe接口允许设备发起DMA操作来访问内存,只要知道目标物理地址即可。目前可用到6.0版本,7.0版本计划于2025年发布。

CXL(计算快速链路)

它是英特尔、AMD等公司联合推出的一种新型高速互连技术,旨在提供更高的数据吞吐量和更低的延迟,满足现代计算和存储系统的需求。CXL技术允许在CPU与设备之间、设备与设备之间共享内存,实现更快、更灵活的数据交换和处理。CXL包含三个子协议:CXL.io、CXL.cache、CXL.memory,分别用于不同的数据传输和内存共享任务。目前已发布到3.1版本。

CXL的一个显著特点是支持内存一致性,这意味着数据可以在不同设备之间共享,而无需复杂的数据复制。这种一致性对于多处理器系统和大规模计算任务尤其重要,因为它可以提高数据访问效率、减少延迟,从而加快计算速度。此外,CXL还具有在各种设备和应用程序中使用的灵活性,使其成为一种通用互连解决方案。

UPI(超级路径互连)

它是英特尔为多核处理器和/或多个处理器之间的高速通信而开发的点对点连接协议,旨在取代之前的QPI(QuickPathInterconnect)技术,提供更高的带宽、更低的延迟和更好的能效。

Infinity Fabric

它是AMD开发的高速互连技术,用于连接AMD处理器内部的各个核心、缓存和其他组件,实现高效的数据传输和通信。InfinityFabric采用分布式架构,包含多个独立通道,每个通道都可以进行双向数据传输。这种设计允许不同核心之间实现快速、低延迟的通信,从而提高整体性能。此外,InfinityFabric具有可扩展性和灵活性,允许不同芯片之间进行连接,并支持将多个处理器组合成更强大的系统。

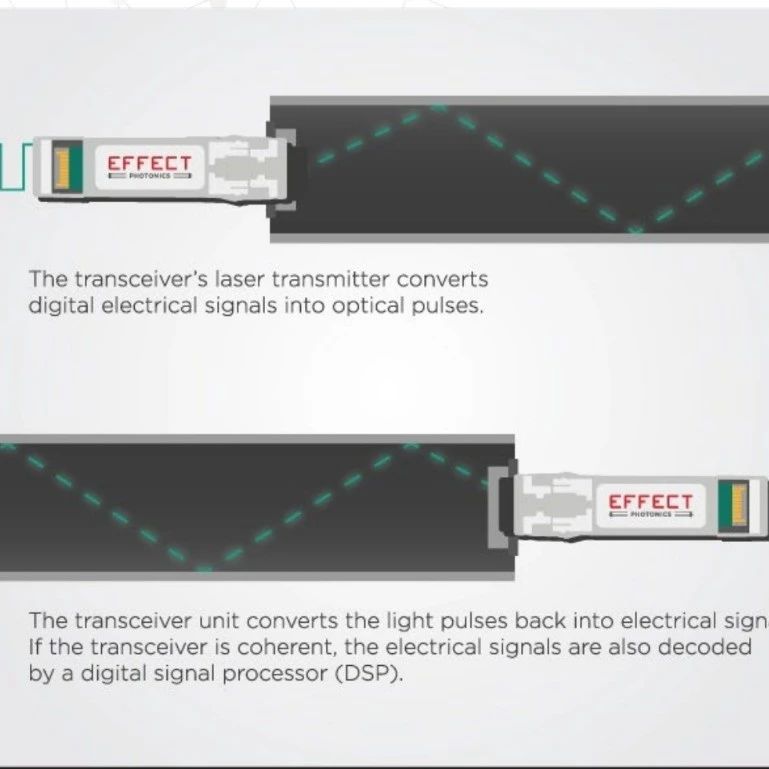

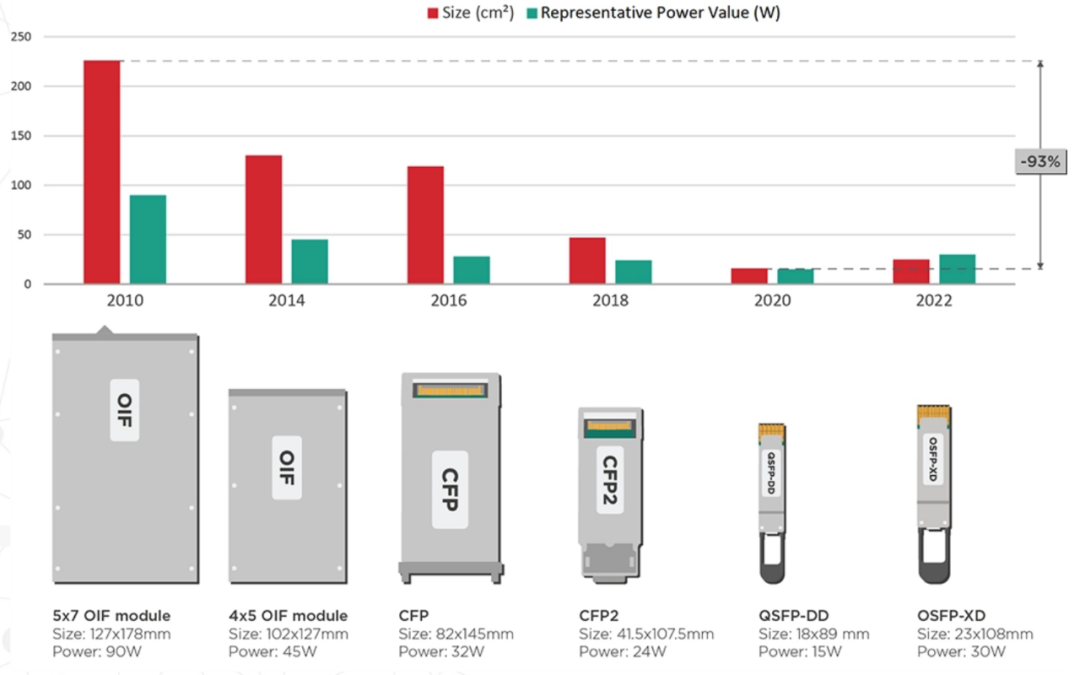

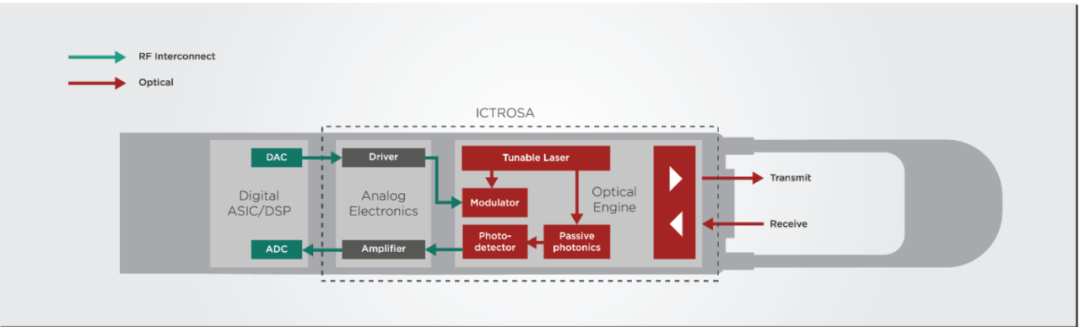

数据中心互连

超大规模数据中心的占地面积相当于几个足球场,对架构速度和智能处理能力提出了前所未有的要求。高速、长距离互联技术可以大幅提升性能,同时实现低延迟计算。数据中心级互联技术是支撑现代互联网服务和云计算的基础。从机架层的高速数据传输到数据中心的网络连接,这些技术共同保障了数据中心的效率、稳定性和可扩展性。

软件定义网络(SDN)

软件定义网络(SDN)是一种网络架构概念,它将网络的控制平面与数据平面分离,允许网络管理员通过软件程序集中管理和配置网络行为。SDN的核心思想是将网络的智能控制功能从网络设备中抽象出来,实现网络流量的动态管理和优化。

以太网和RoCE

以太网是目前应用最为广泛、最为成熟的网络技术,起源于施乐PARC,能够在数据中心的服务器之间传输大量数据,这对于很多加速计算任务至关重要。在RoCE协议下,以太网集成了RDMA功能,大大提升了高性能计算场景下的通信性能。为了应对AI、HPC等工作负载带来的新挑战,网络巨头联合成立了超级以太网联盟(UEC),超级以太网解决方案堆栈将利用以太网的普遍性和灵活性来处理各种工作负载,同时具有可扩展性和成本效益,为以太网注入新的活力。

RoCE(RDMAoverConvergedEthernet):RoCE技术允许在标准以太网上进行远程直接内存访问,通过优化以太网交换机支持RDMA,在保持与传统以太网兼容性的同时,提供高性能的网络连接。

无限带宽

InfiniBand:一种专为高性能计算(HPC)设计的网络技术,提供高带宽、低延迟的网络连接,支持点对点连接和远程直接内存访问(RDMA),适用于大规模计算和数据中心环境。

网络拓扑

常见的拓扑结构有星型网络拓扑、Fat-tree拓扑、Leaf-Spine拓扑、分层拓扑等,这里主要介绍Fat-tree和leaf-spine,它们都是基于CLOS网络模型的数据中心网络架构。

叶脊拓扑

它是一种扁平的网络设计,由Spine层(骨干层)和Leaf层(接入层)组成。每个Leaf交换机连接到所有Spine交换机,形成全网状拓扑。这种设计提供高带宽、低延迟和无阻塞的服务器到服务器连接,易于水平扩展,并且具有高可靠性和易于管理的特点。Leaf-Spine架构的优点包括扁平设计以降低延迟、易于扩展、低收敛率、简化管理和多云管理。

Fat-Tree拓扑

它是一种树形结构的网络设计,通常由核心层、汇聚层和接入层三层组成。Fat-Tree拓扑结构的主要特点在于不存在带宽收敛,即网络带宽不会从叶子向根收敛,这为构建大规模无阻塞网络提供了基础。其各个节点(根节点除外)需要保证上下行带宽相等,所有交换机可以相同,从而降低成本。但是Fat-Tree拓扑结构也有其局限性,例如可扩展性有限、容错性较差、不利于部署某些高性能分布式应用、成本较高等。

核心/边缘网络

核心网是高速率、高可靠的网络主干,负责网络各主要节点之间传输大量数据并提供路由服务;边缘网是网络的接入层,直接连接终端用户和设备,提供多样化服务,优化用户体验。

此文内容来自千家网,如涉及作品内容、版权和其它问题,请于联系工作人员,我们将在第一时间和您对接删除处理!

暂无评论