2023-2024年是人工智能(AI)之元年,越来越多企业关注到AI的潜力,并制定了相关蓝图,其中微软开始进军AI行业,并发布相关产品。

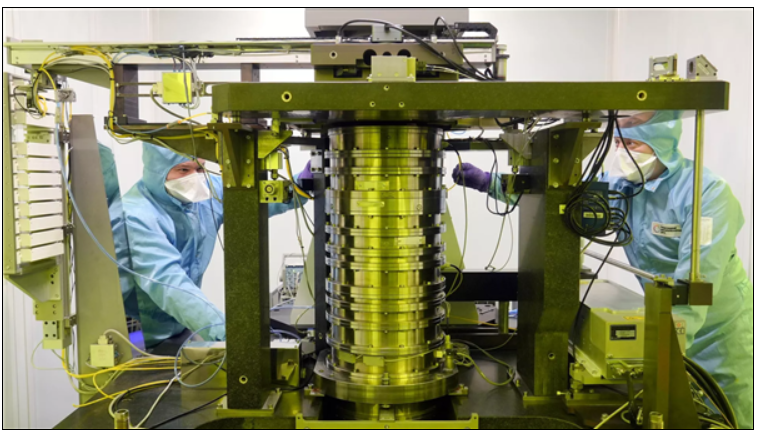

近期,微软公司除夕Hot Chip 2024大会,并在该大会上分享了Maia 100芯片的规格信息。Maia 100是台积电5nm节点上制造的最大处理器之一,专门为部署在Azure中的大规模AI工作负载而设计,其芯片规格如下:

芯片尺寸:820 平方毫米

封装:采用 COWOS-S 夹层技术的 TSMC N5 工艺

HBM BW/Cap;1.8TB/s @ 64GB HBM2E

峰值密集 Tensor POPS: 6bit: 3,9bit: 1.5, BF16: 0.8

L1/L2:500MB

后端网络 BW:600GB/s(12X400gbe)

主机 BW(PCIe):32GB/s PCIe Gen5X8

设计 TDP:700W

Provision TDP:500W

Microsoft Maia 100 系统采用垂直集成方式,以优化成本和性能。它还采用定制服务器板,配备专门设计的机架和软件堆栈,以提高性能。

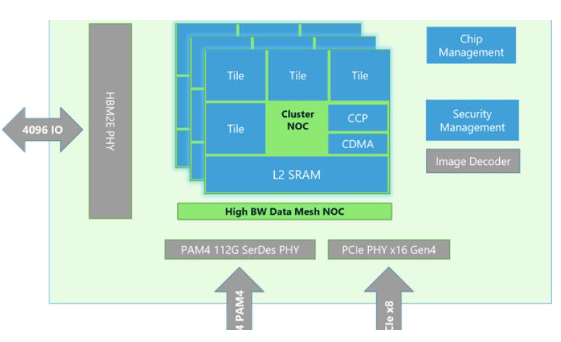

Maia 100 架构

高速 Tensor 单元可为训练和推理提供高速处理,同时支持多种数据类型,单元采用 16xRx16 结构。

矢量处理器是一个松散耦合的超标量引擎,采用定制指令集架构(ISA),支持包括 FP32 和 BF16 在内的多种数据类型。

直接内存访问(DMA)引擎支持不同的张量分片方案。

硬件 semaphores 支持 Maia 系统的异步编程。

为提高数据利用率和能效,大型 L1 和 L2 scratch pads 交由软件管理。

Maia 100 采用基于以太网的互联技术和类似 RoCE 的定制协议,可实现超高带宽计算。它支持高达 4800 Gbps 的 all-gather 和 scatter-reduced 带宽,以及 1200 Gbps 的 all-to-all 带宽。

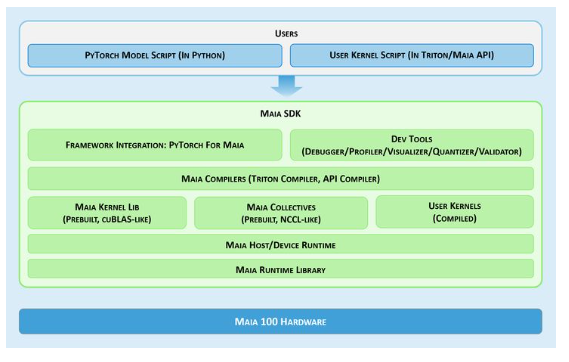

在软件方面,Maia 软件开发工具包(SDK)允许任何人快速将其 PyTorch 和 Triton 模型移植到 Maia。Maia SDK 为开发人员提供了多个组件,使他们能够轻松地将模型部署到 Azure OpenAI 服务。

暂无评论