ChatGPT以现象级通用型聊天机器人席卷全球,成为当下最大的新风口,让所有人都在狂热追逐人工智能应用。然而当人们开始热烈讨论人工智能技术革命,如何创造生产力时,也要考虑实际情况,比如养一个ChatGPT非常非常烧钱。

而且作为一个AI大模型,培养ChatGPT需要的成本不仅包括硬件、软件、人力和数据等,还包括大量的资源。

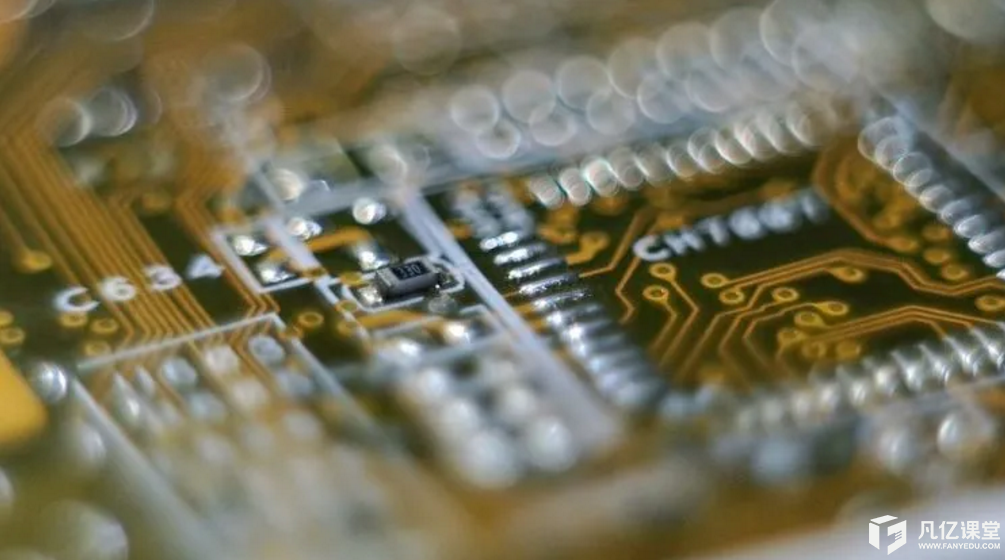

硬件成本方面,需要使用高性能的计算机和专门的硬件加速器,比如GPU、TPU等。这些设备的价格较高,需要进行大量的投资。

数据成本方面,需要使用大量的数据来训练ChatGPT模型,数据的质量和多样性也直接影响模型的性能和效果。获取高质量的数据需要投入大量的成本。

人力和软件成本方面,也需要投入一定的成本。需要一支专业的团队来进行模型的开发、训练和优化,以及进行系统的维护和更新。同时,还需要购买一些软件工具和技术支持服务,比如深度学习框架、模型训练工具等。

但资源方面可以说是耗费巨大,毕竟人工智能处理能力的提升,将永远伴随着资源的大量消耗。

据了解,OpenAI在2023年1月为ChatGPT投入的电力电量相当于12.5万个丹麦家庭一年的用电量,这还是基于目前模型使用情况的预测,若其应用面更广,ChatGPT的消耗规模极有可能达到数百万人的等效用电量。

同时,根据科罗拉多河滨大学和得克萨斯大学的论文指出,仅是ChatGPT上一代的模型——GPT-3训练就用掉了近70万升的水,这足以生产370辆宝马汽车,简单来说,ChatGPT每与用户交流25-50个问题,将“喝下”500毫升的水。鉴于其受欢迎的程度,ChatGPT的存在对当地供水来说是个烫手货。

研究还指出,OpenAI需要为其超级计算机中1万张显卡和超过28.5万个处理器内核提供冷却设备,这一过程足够生产320辆特斯拉汽车的电池。

除此之外还有重金养护维修的成本,这无疑不再说明:培养一个ChatGPT需要的成本较高,需要进行大量的投资和资源的调配。

暂无评论