机器学习作为现代人工智能的最重要的发展之一,是一门多领域交叉学科,包含概率论、统计学、逼近论、凸分析等多门学科,主要用于研究计算机怎样模拟或实现人类的学习行为。今天将盘点十个机器学习的主流算法,看看小伙伴会哪个?

1、线性回归

线性回归是机器学习最常见的算法,是利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法,最常用的技术是最小二乘法。简单来说,是要找一条直线,并且让这条直线尽可能地拟合散点图中的数据点。它试图通过将直线方程与该数据拟合来表示自变量(x 值)和数值结果(y 值)。然后就可以用这条线来预测未来的值。

2、逻辑回归

逻辑回归和线性回归类似,但是它是用于输出为二进制的情况(即结果只能有两个可能的值),也叫作logistics回归,是一种广义的线性回归分析模型。它的原理是将中间结果值映射到结果变量Y,其值范围从0到1,然后这些值可以解释为Y出现的概率,对最终输出的预测是一个非线性的S型函数,常用于数据挖掘、数据分类等。

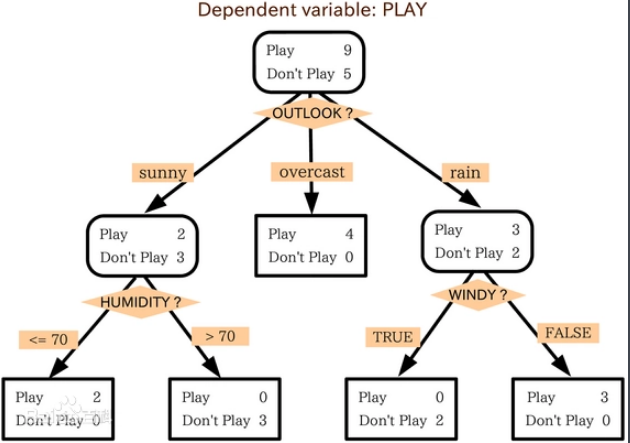

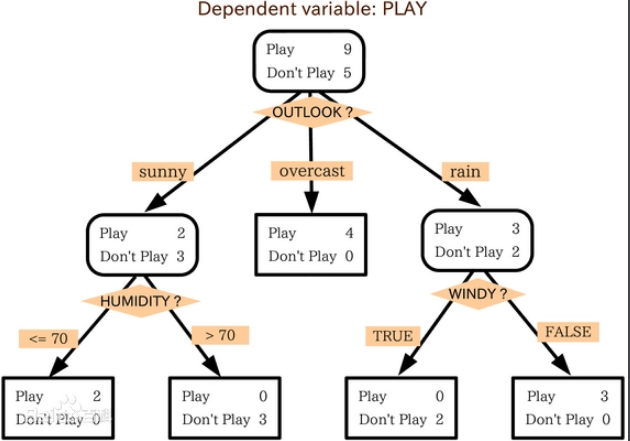

3、决策树

决策树常用于回归和分类任务,决策树的训练模型通过学习树表示的决策规则来学习预测目标变量的值,树是由具有相应属性的节点组成,在每个节点上根据可用的特征可询问有关数据的问题,左右分支代表可能的答案,最终节点对应一个预测值,每个特征点重要性是通过自顶向下方法确定,节点越高,属性越重要。

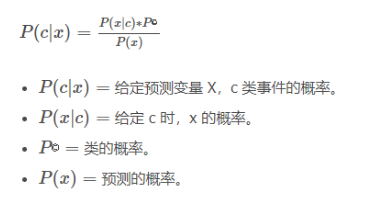

4、朴素贝叶斯

朴素贝叶斯是基于贝叶斯定理与特征条件独立假设的分类方法,它发源于古典数学理论。它测量每个类的概率,每个类的条件概率给出 x 的值。这个算法用于分类问题,得到一个二进制“是 / 非”的结果,具体如下:

5、支持向量机

支持向量机(SVM)是一类按监督学习方式对数据进行二元分类的广义线性分类器,其决策边界是对学习样本求解的最大边距超平面。将数据项绘制为n维空间中的点,其中,n是输入特征的数量。在此基础上,支持向量机找到一个最优边界,称为超平面,它通过类标签将可能的输出进行最佳分离。

6、K-最近邻算法

K-最近邻算法(KNN)是数据挖掘分类技术中的最简单方法之一,其核心思想是如果一个样本在特征空间中的K个最相邻的样本中的大多数属于某一个类别,则该样本也属于这个类别,并具有这个类别上样本的特性。该方法在确定分类决策上只依据最邻近的一个或者几个样本的类别来决定待分样本所属的类别。

7、K- 均值

K- 均值也叫作K平均算法,是通过对数据集进行分类来聚类的,该算法根据每个数据点的特征,将每个数据点迭代地分配给 K 个组中的一个组。它为每个 K- 聚类(称为质心)选择 K 个点。基于相似度,将新的数据点添加到具有最近质心的聚类中。这个过程一直持续到质心停止变化为止。

8、随机森林

随机森林指的是利用多棵树对样本进行训练并预测的一种分类器,基本思想是多人意见比个人意见更准确。为了对新对象进行分类,我们从每个决策树中进行投票,并结合结果,然后根据多数投票做出最终决定。

(a)在训练过程中,每个决策树都是基于训练集的引导样本来构建的。

(b)在分类过程中,输入实例的决定是根据多数投票做出的。

9、降维

通常来说,随着时代发展,所捕获的数据量越来越多,机器学习问题变得更加复杂,意味着训练变得更加缓慢,而且很难找到一个好的解决方案,这种问题叫做维数灾难。

降维是在保证不丢失最重要信息的前提下,通过将特定的特征组合成更高层次的特征来解决这个问题,最常用的技术是主成分分析。

10、人工神经网络

人工神经网络(ANN)的原理是从信息处理角度对人脑神经元网络进行抽象, 建立某种简单模型,按不同的连接方式组成不同的网络。它本质上是一组带有权值的边和节点组成的相互连接的层,称为神经元。

暂无评论